Alors que le Japon et les États-Unis viennent de s’affronter dans un combat à mort de robots géants, loin derrière le spectacle, l’utilisation de vrais robots de guerre fait son entrée par la porte de derrière, en toute discrétion…

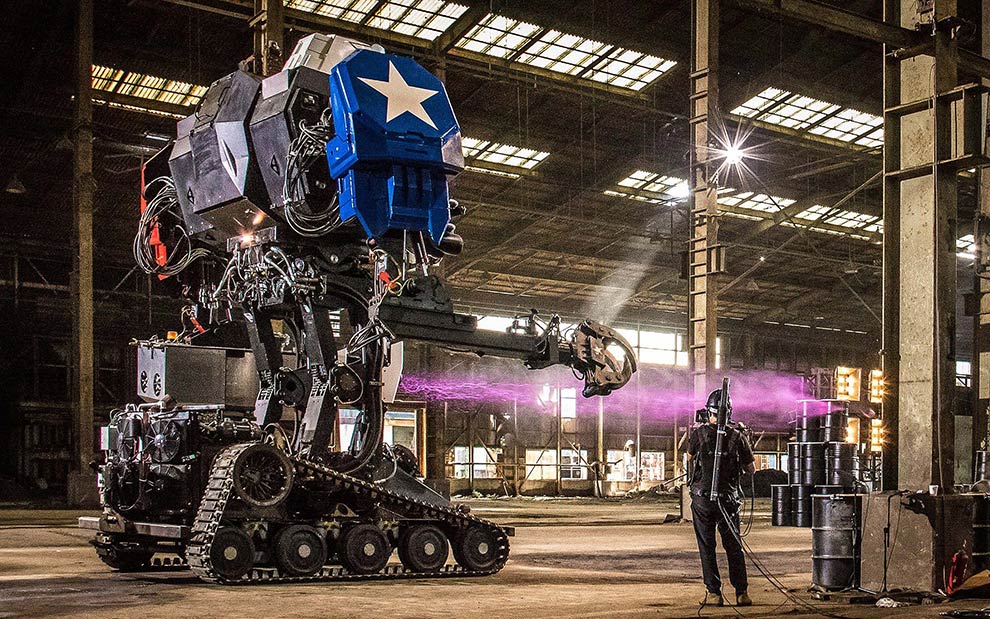

Le 17 octobre, la planète robot était en effervescence. À 19H (heure du Pacifique) avait lieu au Japon un combat robotique « historique » opposant deux machines de guerre armées pour se jeter dans une mêlée sans pitié. Oubliez Battlebots et ses petites machines, ici nous parlons de mastodontes de plusieurs tonnes équipés comme si elles partaient en guerre. D’un côté, nous avons le MKII Megabot de la société américaine Megabots pesant 12000 lb (environ 5443 kg), d’un autre le KURATAS de la société japonaise Suidobashi Heavy Industries de 9000 lb (environ 4082 kg).

Le combat attendu depuis plusieurs années sera visionné par près de 2 millions de personnes. Mais derrière ce spectacle populaire, s’annonçant finalement très décevant, se cache une sombre réalité, beaucoup moins médiatisée mais pourtant cruciale car son évènement peut marquer un tournant historique dans la technologie militaire voire pour l’humanité : l’usage de machines taillées pour la guerre, en intervention réelle sur le terrain. Le réel rattrape peu à peu la fiction et rares semblent ceux à s’en inquiéter.

La mort métallique approche inévitablement

Selon le site Defense One, le Phantom, un robot de combat conçu comme un véhicule tout-terrain, devrait être déployé d’ici l’année prochaine en Ukraine pour épauler les forces ukrainiennes face à la Russie, si les tests sont concluants. Équipé de mitrailleuses, de lance-grenades ou d’armes antichar, sa mission serait principalement d’appuyer les troupes au sol en servant de couverture ou d’évacuation de blessés. Naturellement, son look actuel est moins romanesque que dans l’imaginaire hollywoodien. Mais la machine est d’une redoutable efficacité, et c’est tout ce qui compte.

À l’heure où la communauté internationale braque son regard sur le danger nucléaire suite aux multiples essais effectués par la Corée du Nord, puis à l’attribution du Prix Nobel de la Paix à l’ICAN (International Campaign to Abolish Nuclear Weapons), la question du développement des robots de guerre semi-autonomes ne devrait-elle pas également nous alerter ? Comme pour le nucléaire, le débat existe depuis de nombreuses années sur la limitation voire l’interdiction totale de cette technologie, mais ce débat peine à percer dans l’opinion plus générale. Il faut dire, la culture populaire, autant cinématographique qu’animée ou écrite, semble nous avoir accoutumés à cette dystopie tragique.

Actuellement, on définit le robot tel un engin de combat dont le pilote ne se trouve pas à l’intérieur mais à distance de sécurité. Se présentant essentiellement sous la forme d’un véhicule à outils, il est dirigé via un poste de pilotage également mobile par un soldat pouvant observer les mouvements via une caméra et diriger l’engin grâce à des joysticks.

Ceci s’applique par exemple aux drones, des avions sans pilote servant à des missions de reconnaissance ou d’élimination de cibles importantes comme les dirigeants de groupes terroristes. Techniquement, les drones militaires sont donc déjà des robots de première génération en fonction.

Donc, un robot agit comme un char ou un avion à la différence que le pilote ne se trouve plus à l’intérieur mais à l’extérieur de la machine de guerre, permettant de réduire la taille de l’engin et donc d’augmenter son efficacité. Ce qui inquiète cependant les détracteurs, comme le PDG de Tesla Elon Musk, le cofondateur d’Apple Steve Wozniak ou encore l’astrophysicien Stephen Hawking (qui appellent tout les trois à une législation internationale stricte sur la question), c’est le risque qu’apparaissent à grande échelle les « robots tueurs autonomes » capables de décider, via une intelligence artificielle élémentaire, de tuer ou non une cible. Ce type de développement étant prévisible, faut-il attendre pour l’encadrer ?

Vidéo de promotion du « Phantom »

La double faille des robots tueurs

Comme pour toutes les nouvelles technologies, celle des robots tueurs autonomes fait débat entre défenseurs et détracteurs sur diverses problématiques non seulement militaires mais aussi humaines. S’il était déjà une question hautement éthique de remettre le pouvoir de tuer un être humain à un autre être humain, comment pourrait-on donner ce pouvoir à une machine sans soulever un débat de fond impliquant la société entière ?

D’abord, la sécurité mise en place autour de son usage. Bien que l’intelligence artificielle ne soit pas encore développée pour agir indépendamment, les détracteurs craignent que celle-ci souffre des deux problèmes que peuvent connaitre les ordinateurs : le piratage et la défaillance. Aujourd’hui, l’informatique est une composante importante, non seulement dans la société civile, mais aussi dans l’armée. Le cyberpiratage et la cybersécurité sont des sujets pris très au sérieux par les officiels politiques et militaire. Dans un monde hyper-connecté, un pirate s’attaquant à une centrale nucléaire ou à une institution financière peut réaliser d’énormes dégâts s’il dispose de la formation nécessaire pour outrepasser les systèmes de sécurité. Ce point peut aussi s’appliquer pour les robots tueurs autonomes où la manipulation de l’intelligence artificielle pourrait entrainer une attaque sur des militaires (ou civils) par leurs propres machines. Quant à la défaillance, la crainte serait que l’intelligence n’interprète pas correctement la situation et décide de tuer alors qu’elle ne le devrait pas, selon les protocoles encodés.

Face à cette critique, les défenseurs rappellent qu’actuellement, il n’est pas encore envisagé de rendre tous robots totalement libres, surtout dans le processus décisionnel. Il y aura toujours un contrôle humain qui décidera de modifier ou d’annuler un ordre. Selon eux, « autonome » ne signifie pas à ce jour « totalement indépendant » mais « agir sans être directement dirigé ». Jouerait-on sur les mots ? À ce stade, leur développement répond à la nécessité d’intégrer de nouvelles technologies comme la cybernétique dans les véhicules de combat.

Le robot tueur est-il responsable de ses actes ?

Vient le volet juridique en ce qui concerne la responsabilité « individuelle » du robot tueur autonome. Doit-il être tenu comme responsable s’il tue quelqu’un ? Juridiquement, seule une personne morale reconnue peut être jugée et condamnée. Or, la machine n’en est pas une, en raison de son statut actuel d’objet. Ce serait donc les militaires qui devraient endosser la responsabilité pénale. Ceci crée un étonnant paradoxe. Même une machine programmée pour tuer ne serait pas responsable, selon l’état actuel des lois. Quid en cas de piratage ? L’association Human Right Watch dénonce ce vide juridique dans le droit international et craint que l’armée en profite pour se disculper de toute responsabilité en cas de dommages collatéraux en invoquant le problème technique, rendant plus difficile la recherche des responsables.

Enfin, l’usage de telles armes posent la question de l’éthique dans leur utilisation. Aujourd’hui, lors des opérations militaires, la vie humaine est plus valorisée qu’auparavant. Les plans d’opération doivent tenir compte du risque de pertes humaines afin de les limiter. Les défenseurs pensent que les robots autonomes supprimeraient cette contrainte car les soldats ne seraient plus envoyés dans les zones très dangereuses, ce qui permettraient de les épargner pour d’autres affectations moins risquées et pénibles. Les détracteurs en revanche ne voient pas seulement le problème du point de vue de celui qui les emploie, mais de tous les êtres humains (dont les civils en terrain ennemi). Est-il éthique de laisser à une machine plutôt qu’à un humain le droit de vie et de mort sur une cible quelconque ? Un robot serait-il capable d’évaluer une situation dans toute sa dimension humaine (empathie, compassion,..) ? La principale peur serait que l’usage des robots tueurs supprime la contrainte éthique et puisse servir à effectuer le « sale boulot », avec ou sans témoins, comme la répression des populations civiles dans les régimes autoritaires ou les attentats terroristes.

Un scénario à la Terminator pour demain ?

Qu’en est-il de la communauté internationale ? Existe-il une résolution encadrant les robots tueurs autonomes à ce jour ? La réponse est non. La coalition internationale Campaign to Stop Killer Robots dénonce cette lenteur et craint que des États en profitent pour avancer dans leurs recherches visant à développer des robots tueurs indépendants. Selon la coalition, 6 États se sont lancés dans la recherche, le développement et l’expérimentation de ceux-ci : les États-Unis, la Chine, la Russie, le Royaume-Uni, la Corée du Sud et Israël. Tôt ou tard, ces robots vont voir le jour ! C’est une question de temps.

De plus en plus États ont ainsi conscience du danger que ces armes peuvent représenter pour la paix globale. Prochainement, une réunion du Groupe d’experts gouvernementaux (GGE), établi en 2016 dans le cadre de la Convention sur certaines armes classiques (CCAC), doit se tenir les 13 et 17 novembre avec la participation de 90 États et de groupes internationaux dont Campaign to Stop Killer pour encadrer le cyberespace et les robots tueurs autonomes suite à une lettre signée par des dizaines de dirigeants d’entreprises sur la cybernétique. Si les discussions avancent, il est prévu qu’à partir de fin 2018, des négociations du GGE devront se tenir pour compléter la CCAC avec un protocole visant à prohiber les armes totalement autonomes.

Pour l’instant, on peut respirer. Il n’existe pas encore de robots humanoïdes ou de véhicules sans pilotes dirigés par une intelligence artificielle déployés sur un champ de bataille. Seuls des systèmes de sécurité sont utilisés à des objectifs purement défensifs comme le système antimissile Iron Dome en Israël pour détruire les roquettes lancées depuis Gaza ou le SGR-A1 de Samsung déployé dans la partie sud-coréenne de la zone démilitarisée pour surveiller et neutraliser les intrus, sauf que ce dernier est critiqué pour son incapacité à distinguer précisément les cibles.

En attendant, la course à l’armement dans la robotique est une réalité de notre temps. Le possible déploiement du Phantom en Ukraine montre que les robots feront bientôt partie de la guerre conventionnelle. Face à cela, la Russie dispose aussi de robots tels que le Platforma-M, le Nerehta et l’Uran-9 (ressemblant tous à des chars). L’invasion de Terminators n’est donc pas pour tout de suite et ne le sera probablement jamais si un accord international est trouvé … à condition que tous acceptent de le signer ! Finalement, c’est bien le facteur humain qui tranchera l’avenir.

Co-écrit par Un Coin de cerveau & MrMondialisation

Vous appréciez nos écrits gratuits et indépendants ? Remerciez-nous aujourd’hui par un simple café. ?

Sources : An Open Letter to the United Nations Convention on Certain Conventional Weapons, Future of Life Institute : Cambridge, futureoflife.org

Experts on killer robots at Davos, Campaign to Stop Killer Robots, 22 janvier 2016, stopkillerrobots.org

JOIGNOT Frédéric, Faut-il interdire les robots tueurs autonomes?, Le Monde : Paris, lemonde.fr

Megabots, megabots.com

Menaces mondiales à l’horizon : la cyberguerre et les robots tueurs, UNRIC : Bruxelles, 7 septembre 2017, unric.org

TUCKER Patrick, Armed Ground Robots Could Join the Ukrainian Conflict Next Year, Defense One : Washington DC, 10 octobre 2017, defenseone.com